- Автоматизация

- Антропология

- Археология

- Архитектура

- Биология

- Ботаника

- Бухгалтерия

- Военная наука

- Генетика

- География

- Геология

- Демография

- Деревообработка

- Журналистика

- Зоология

- Изобретательство

- Информатика

- Искусство

- История

- Кинематография

- Компьютеризация

- Косметика

- Кулинария

- Культура

- Лексикология

- Лингвистика

- Литература

- Логика

- Маркетинг

- Математика

- Материаловедение

- Медицина

- Менеджмент

- Металлургия

- Метрология

- Механика

- Музыка

- Науковедение

- Образование

- Охрана Труда

- Педагогика

- Полиграфия

- Политология

- Право

- Предпринимательство

- Приборостроение

- Программирование

- Производство

- Промышленность

- Психология

- Радиосвязь

- Религия

- Риторика

- Социология

- Спорт

- Стандартизация

- Статистика

- Строительство

- Технологии

- Торговля

- Транспорт

- Фармакология

- Физика

- Физиология

- Философия

- Финансы

- Химия

- Хозяйство

- Черчение

- Экология

- Экономика

- Электроника

- Электротехника

- Энергетика

Расчет информационных парметров сообщения.

3.Расчет информационных парметров сообщения.

Задание 3.1

Определить энтропию,количество информации и избыточность сообщения состоящего из букв Фамилии Имени Отчество студента.

Решение задания 3.1

Сообщение «Чернавин Денис Леонидович».

Длина сообщения:n=8+7+9=23 буквы.

Алфавит, используемый в сообщении:

α∈{Ч,е,р,н,а,в,и,,Д,с,л,о }

Количество букв: m=11 букв.

Частота появления букв в сообщении:

«ч» - встречается 2 раза, n(ч)=2;

«е» - встречается 3 раза,n(е)=3;

«р» - встречается 1 раз,n(р)=1;

«н» - встречается 4 раза,n(н)=4;

«а» - встречается 1 раз,n(а)=1;

«в» - встречается 2 раза,n(в)=2;

«и» - встречается 4 раза,n(и)=4;

«д» - встречается 2 раза,n(д)=2;

«с» - встречается 1 раз,n(с)=1;

«л» - встречается 1 раз,n(л)=1;

«о» - встречается 2 раза,n(о)=2;

Находим вероятности появления букв:

p(р)=p(а)=p(с)=p(л)= 1/23;

p(ч)=p(в)= p(д)= p(0)=2/23;

p(е)=3/23;

p(н)= p(и)= 4/23;

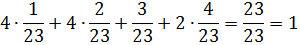

Проверяем правильность расчета по формуле полной вероятности:

6p(л)+2p(в)+ p(д) +p(а)+p(е)=1;

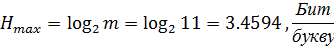

Находим максимальную энтропию по формуле:

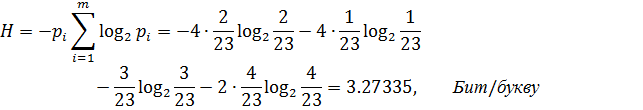

Теперь находим энтропию по формуле (символы неравновероятны):

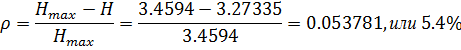

Далее находим избыточность:

Считаем количество информации в сообщении:

Задание 3.2

Представить фамилию студента в виде двоичного кода UTF, исключив четыре первых нуля каждой буквы. Определить условные вероятности p(0/0),p(1/0),p(0/1),p(1/1) и условную энтропию сообщения.

|

|

|

© helpiks.su При использовании или копировании материалов прямая ссылка на сайт обязательна.

|