- Автоматизация

- Антропология

- Археология

- Архитектура

- Биология

- Ботаника

- Бухгалтерия

- Военная наука

- Генетика

- География

- Геология

- Демография

- Деревообработка

- Журналистика

- Зоология

- Изобретательство

- Информатика

- Искусство

- История

- Кинематография

- Компьютеризация

- Косметика

- Кулинария

- Культура

- Лексикология

- Лингвистика

- Литература

- Логика

- Маркетинг

- Математика

- Материаловедение

- Медицина

- Менеджмент

- Металлургия

- Метрология

- Механика

- Музыка

- Науковедение

- Образование

- Охрана Труда

- Педагогика

- Полиграфия

- Политология

- Право

- Предпринимательство

- Приборостроение

- Программирование

- Производство

- Промышленность

- Психология

- Радиосвязь

- Религия

- Риторика

- Социология

- Спорт

- Стандартизация

- Статистика

- Строительство

- Технологии

- Торговля

- Транспорт

- Фармакология

- Физика

- Физиология

- Философия

- Финансы

- Химия

- Хозяйство

- Черчение

- Экология

- Экономика

- Электроника

- Электротехника

- Энергетика

Практическая работа №2 «Измерение количества информации»

Практическая работа №2 «Измерение количества информации»

Количество возможных событий и количество информации.

Существует формула, которая связывает между собой количество возможных событий N и количество информации I:

N=2I (1)

По этой формуле можно легко определить количество возможных событий, если известно количество информации.

Количество информации в сообщении (Iс) можно подсчитать, умножив количество информации, которое несет один символ (I), на количество символов (K) в сообщении:

Iс = I × K (2)

Количество информации при вероятностном подходе можно вычислить, пользуясь следующими формулами.

1. Формула Хартли:

Пусть в некотором сообщении содержатся сведения о том, что произошло одно из N равновероятных событий (равновероятность обозначает, что ни одно событие не имеет преимуществ перед другими). Тогда количество информации, заключенное в этом сообщении, — i битов и число N связаны формулой:

N = 2IилиI = log2N, (3)

где N— количество равновероятных событий (число возможных выборов),I — количество информации.

— логарифм N по основанию 2. Если N равно целой степени двойки (2, 4, 8, 16 и т. д.), то такое уравнение можно решить «в уме». В противном случае количество информации становится нецелой величиной, и для решения задачи придется воспользоваться таблицей логарифмов, которая приведена в Приложении 1.

2. Модифицированная формула Хартли:

I = - log 2 (1/p) = log 2 p , (4)

где р — вероятность наступления каждого из N возможных равновероятных событий.

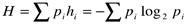

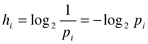

3. Формула Шеннона:

,

,

где pi — вероятность появления в сообщении i-го символа алфавита;

— количество информации, которую несёт появление в тексте i-го символа алфавита;

— количество информации, которую несёт появление в тексте i-го символа алфавита;

H — среднее значение количества информации, приходящееся на один символ алфавита.

|

|

|

© helpiks.su При использовании или копировании материалов прямая ссылка на сайт обязательна.

|